1.导读

聚合物基复合材料具有重量轻、比强度高的优点,在航空航天领域得到了广泛的应用。聚合物基复合材料在先进航空航天结构中的应用可以实现减重和降低成本。然而,由于编织聚合物复合材料的制备过程复杂,不可避免地会出现裂纹和孔洞等初始缺陷。因此,表征复合材料的内部结构是研究复合材料力学性能和使用状态的重要途径之一。传统的表征方法依赖于大量的实验,这些实验通常既昂贵又耗时。因此,基于一个更能描述物体本征内部结构的数字模型是很有必要的。

2023年,《Composite Structures》期刊发表了北京理工大学在基于ResL-U-Net卷积神经网络的编织聚合物复合材料数字孪生方面的研究工作,论文标题为“Material twins generation of woven polymer composites based on ResL-U-Net convolutional neural networks”。

本文提出了一种ResL-U-Net卷积神经网络,其中使用了Leaky ReLU激活函数来提高效率。使用残差结构来防止网络退化,并获得优异的鲁棒性和准确性。通过三维空间映射将初始制造缺陷植入有限元模型中,一方面确保了缺陷的真实性,另一方面也确保了高质量的网格。基于该数字材料孪生方法,研究了玻璃纤维增强树脂聚合物(GFRP)材料的损伤演化和断裂特征;同时,制定了在位CT拉伸实验以验证模拟结果。结果表明,基于材料孪生的模拟很好地验证了GFRP的力学性能,尤其是在损伤位置和材料失效模式方面。

2.内容简介

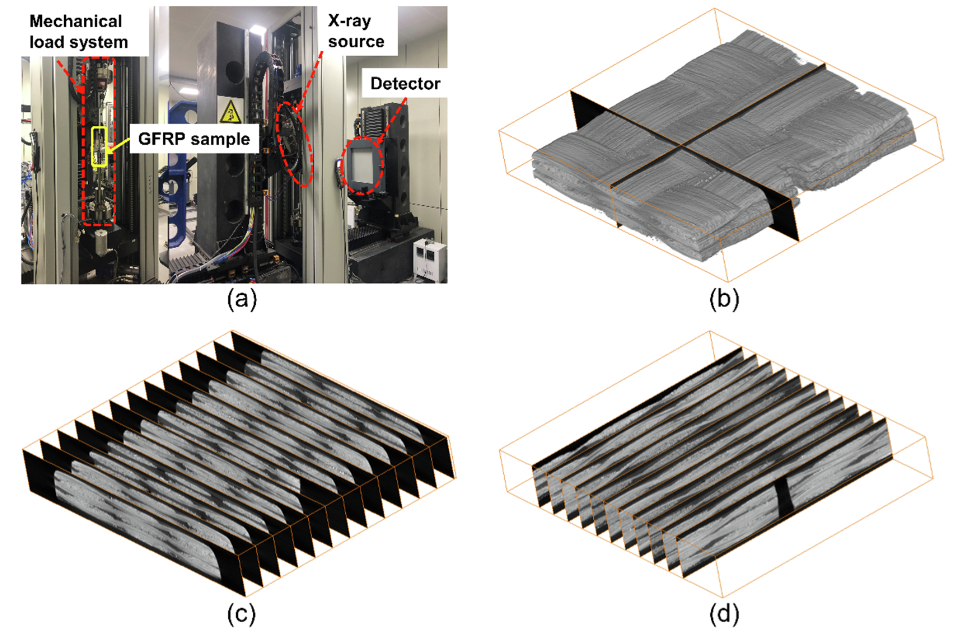

在第2节中,使用X射线微机断层扫描获得GFRP的CT图像,如图1所示。

图1 GFRP断层图像

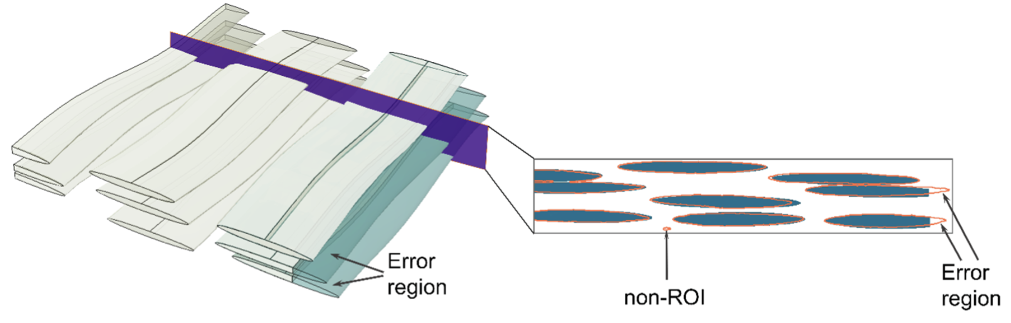

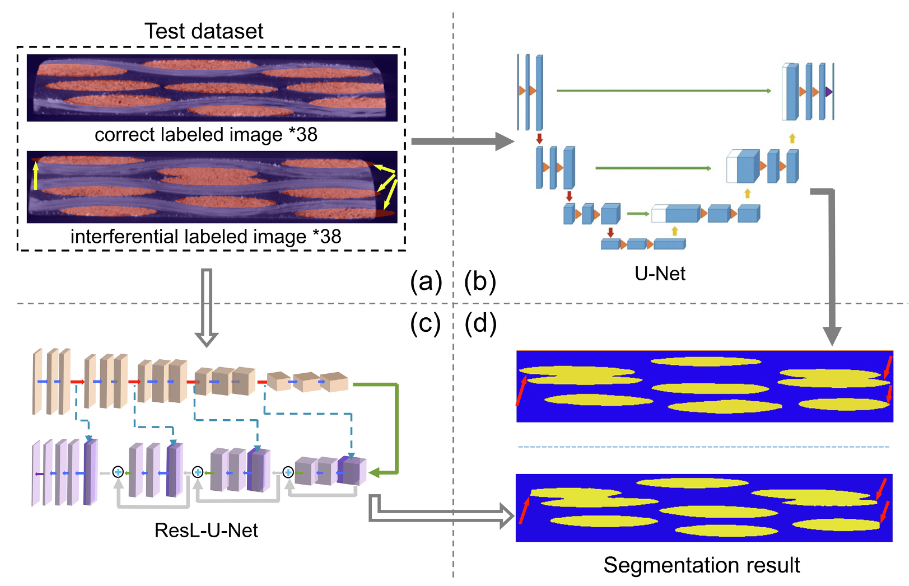

使用U-Net神经网络对图像分割进行初步尝试。通过对分割结果的分析,发现U-Net网络对数据集表现不佳,分析原因主要在于:a.由网络退化引起的分割准确性降低;b.不同类型的边界对网络的干扰。

图2. U-Net图像分割

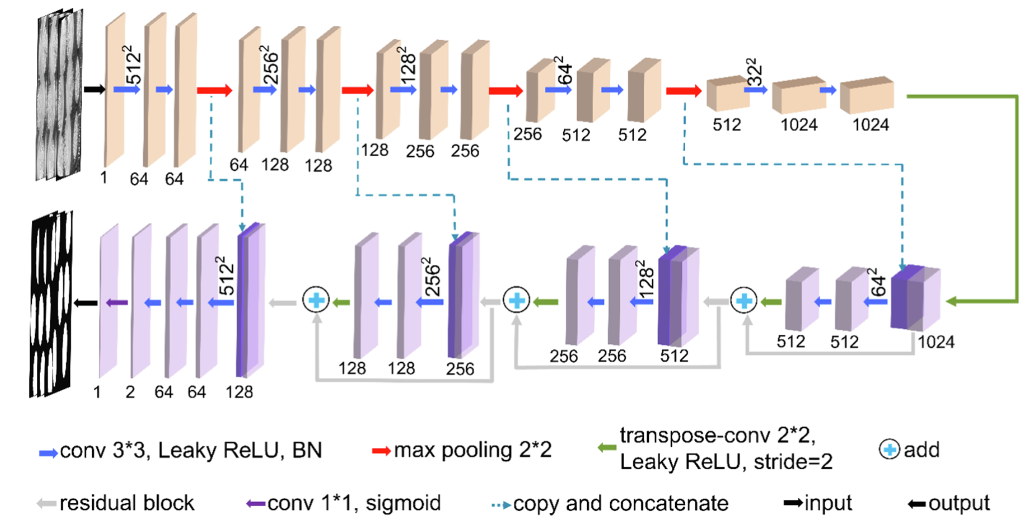

针对U-Net中暴露的问题,设计了一种新的ResL-U-Net网络,该网络更适合低分辨率图像。通过分析所提出的网络的分割结果,验证了ResL-U-Net网络具有更高的准确性和鲁棒性。

图3 ResL-U-Net卷积神经网络体系结构

图4 鲁棒性分析

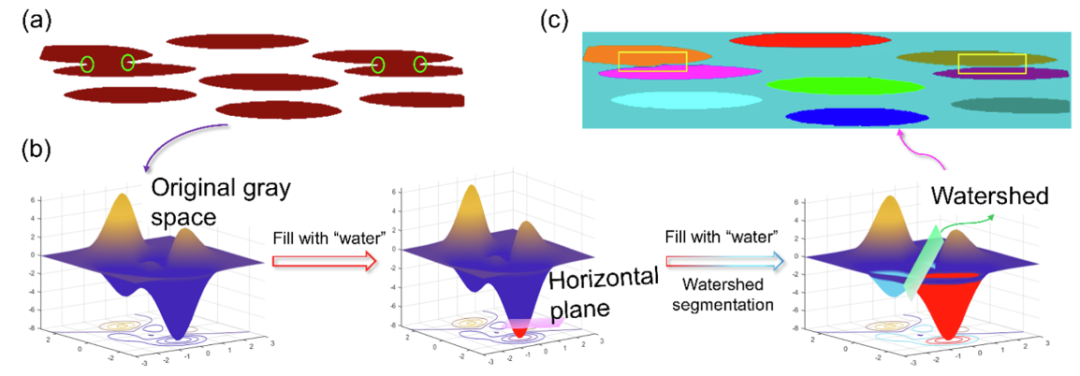

此外,使用凹面检测和分水岭算法的组合来分离图像中连接的纤维纱。

图5 凹面检测与分水岭算法分离连接纤维束

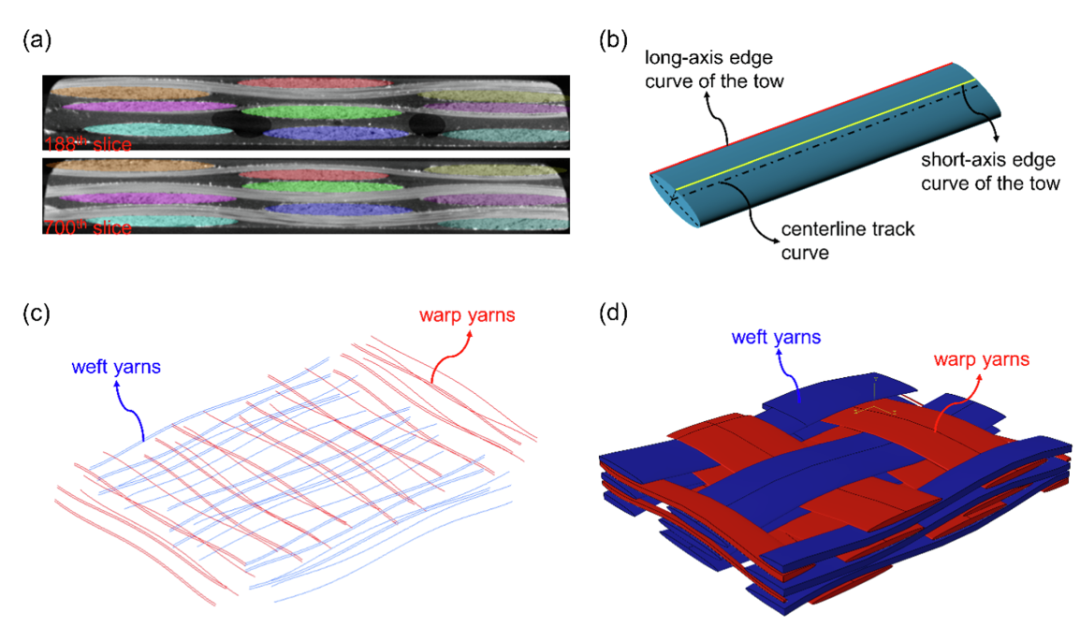

在第3节中,基于优化椭圆拟合方法获得了纤维束的三条参考线:中心线轨迹曲线和长轴与短轴之间的边界曲线。然后,在ProE5.0中生成纤维束的数字材料孪生体,如图6所示。

图6 逐步生成纤维束数字孪生体的过程

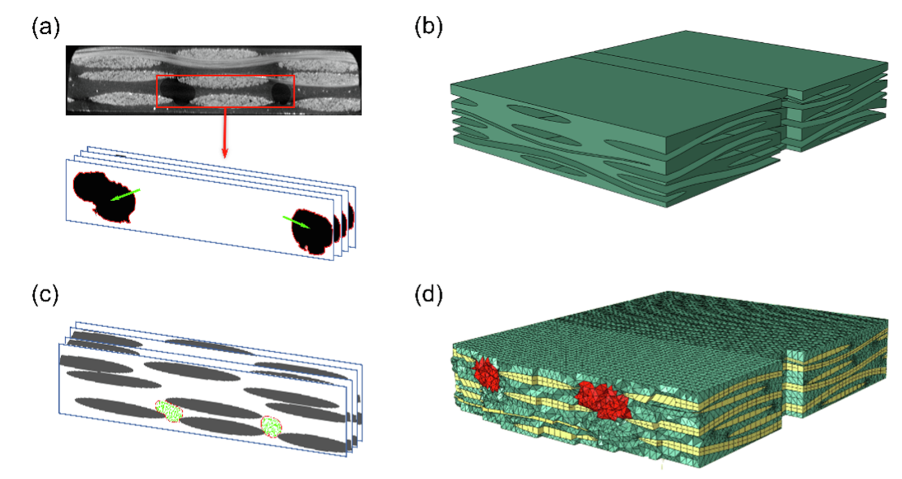

根据几何的布尔逻辑运算生成无缺陷的基体模型,并通过去除代表缺陷的单元来获得具有初始缺陷的基体网格模型,如图7所示。

图7 逐步生成GFRP数值孪生体的过程

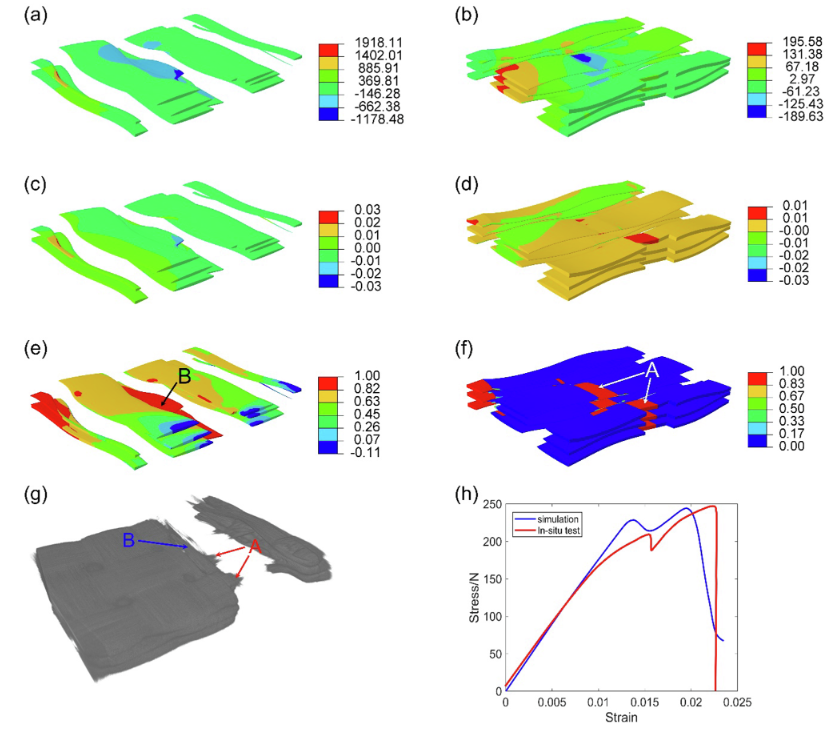

在第4节中,对数字材料孪生体进行了静态模拟,文章中使用的渐进损伤准则是一种基于应变的连续损伤公式,针对树脂基体和玻璃纤维丝束使用不同的失效标准则。随后将结果与在位试验进行了比较,模拟得到的破坏应变为1.96%,强度为244.19MPa,而现场试验得到的破坏变形为2.27%,强度为247.12MPa。应变误差为14%,强度误差为1.2%,均在允许误差范围内。仿真结果如图8所示,证明了数字材料孪生体的准确性。

图8 数字孪生模拟结果

3.小结

本文提出了一种基于μCT图像的生成数字孪生框架,该框架在很大程度上是自动化的。它提出了一个完整的系统,包括第一步的μCT图像分割(ResL-U-Net)和第二步的高保真数字材料孪生体生成。

(1)本文提出了一种新的ResL-U-Net网络,用于GFRP材料的低对比度μCT图像的分割。解决了U-Net网络的准确性低、鲁棒性差的问题。

(2)本文提出了一种将凹面检测与分水岭相结合的算法,解决了连接纤维束的定位问题,然后使用改进的分水岭算法分离纤维束,避免了经纱和纬纱的相互渗透。

(3)通过基于三维表面的空间映射方法,将初始制造缺陷映射到基体中,建立了具有真实缺陷的复合数字材料孪生体。通过与在位试验结果的比较,误差小于15%,验证了该方法的有效性。

原始文献:

Song Y, Qu Z, Liao H, et al. Material twins generation of woven polymer composites based on ResL-U-Net convolutional neural networks[J]. Composite Structures, 2023: 116672.

原文链接:

https://www.sciencedirect.com/science/article/pii/S0263822323000168